Über uns

Unsere Expertise, Ihr Erfolg. Seit über 50 Jahren.

Die Ratiodata ist seit über 50 Jahren ein mehrfach ausgezeichneter IT-Dienstleister und Managed Service Provider. Wir setzen auf maßgeschneiderte Konzepte und liefern IT-Hardware, -Software und -Services mit zertifizierter Qualität und höchsten Sicherheitsstandards. Unsere Expertise konzentriert sich auf die Entwicklung von Lösungen für Kunden mit komplexen IT- und Digitalisierungsbedarfen sowie hohen regulatorischen Anforderungen – nicht zuletzt dank unserer Wurzeln in der Genossenschaftlichen FinanzGruppe.

Die Ratiodata SE ist der Systemhauspartner der Unternehmensgruppe Atruvia AG

1972

gegründet

+1.500

Mitarbeiter*innen

10

Standorte

~333,1

Mio. Euro Umsatz im Jahr 2023

Immer in Ihrer Nähe mit viel Erfahrung und Servicestärke.

Als zuverlässiger IT-Partner und Managed Service Provider legen wir großen Wert darauf, jederzeit schnell reagieren zu können. Mit 1.500 Mitarbeiter*innen und bundesweit zehn Standorten und 22 Campus-Teams zählen wir zu den größten Systemhäusern und Technologiepartnern in Deutschland. Als 100-Prozent-Tochter von Atruvia AG sind wir der Systemhauspartner der Genossenschaftlichen FinanzGruppe Volksbanken Raiffeisenbanken. In Luxemburg ist unsere Schwestergesellschaft Ratiodata Luxemburg S.à r.l. ansässig.

Mit einem bundesweit flächendeckenden Netz von Servicetechniker*innen und leistungsstarken Kompetenzzentren stehen wir für zuverlässige Dienstleistungen rund um IT- und SB-Infrastruktur. Im Segment Banken-SB sind wir Multivendor und Marktführer für herstellerunabhängige Dienstleistungen.

Zu finden sind wir in Münster, Frankfurt am Main, Berlin, Karlsruhe, Duisburg,

Kassel, Hannover, Koblenz und Velburg. Und natürlich direkt vor Ort bei unseren Kunden.

Unsere Kernkompetenzen liegen in den Bereichen:

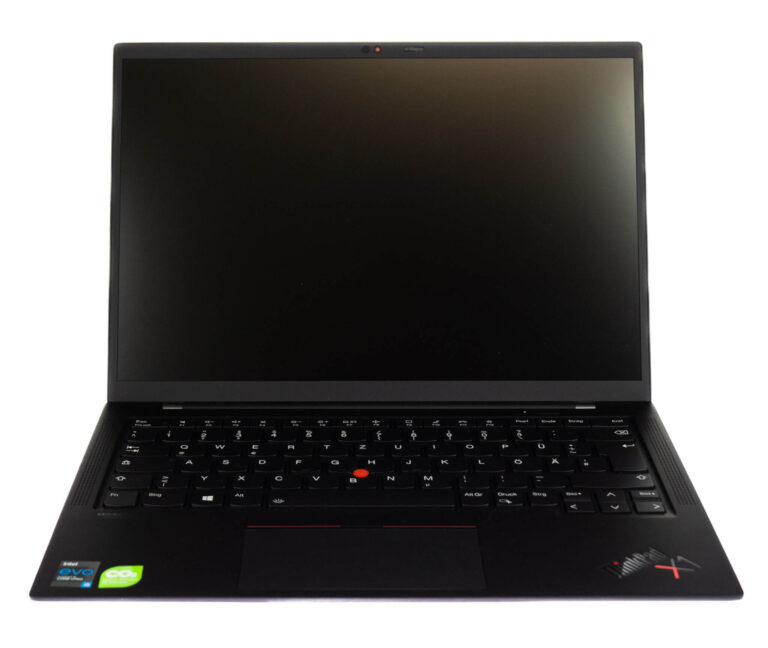

- IT-Infrastruktur & Workplace-Systeme & Lösungen

- Netzwerk- & IT-Security

- Hardwarebeschaffung, Rollout & Services

- Managed- & Field-Service bundesweit

- Betankungs-, Reparatur-, Test- & Zertifizierungszentren

- Scan- & Dokumenten-Services

Zertifizierte Leistung, bewährte Qualität.

Wir legen höchsten Wert auf Qualität und Sicherheit. Durch umfangreiche Zertifizierungen sind wir am Markt als vertrauenswürdiger und hochleistungsfähiger Anbieter bestens aufgestellt.

- ISO 9001:2015 | Qualitätsmanagementsystem (QMS)

- ISO 14001:2015 | Umweltmanagementsystem (UMS)

- ISO/IEC 27001:2013 | Informationssicherheitsmanagementsystem (ISMS)

- IDW PS 951 (Typ 2) | Dienstleistungsbezogenes Internes Kontrollsystem (IKS)

- BSI TR-03138 (TR-RESISCAN) | Technische Richtlinie Ersetzendes Scannen

- Zertifiziertes Unternehmen für öffentliche Auftraggeber (PQ)

Hohe Branchenexpertise und Kundenzufriedenheit bestätigen uns neben eigenen Befragungen auch die mehrfachen Auszeichnungen als „Bester IT-Dienstleister” und „Bester Managed Service Provider” von ChannelPartner und COMPUTERWOCHE.

Für unsere Innovationskraft zeichnete uns „Die Deutsche Wirtschaft“ für verschiedene IT-Lösungen die vergangenen drei Jahre in Folge als „Innovator des Jahres“ aus.

Wir als Ratiodata verstehen Nachhaltigkeit als Chance uns bewusst mit den Auswirkungen unseres wirtschaftlichen Handelns auseinanderzusetzen. Für unser nachhaltiges Wirtschaften erhielten wir den Bronze-Status der unabhängigen Rating-Agentur EcoVadis.

Hier erhalten Sie weitere Informationen zu unseren Zertifizierungen und Nachhaltigkeitsaktivitäten.

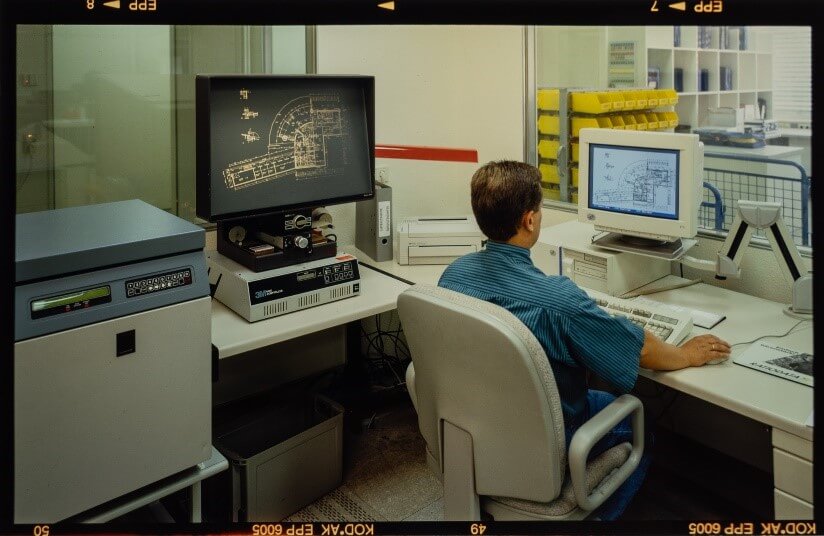

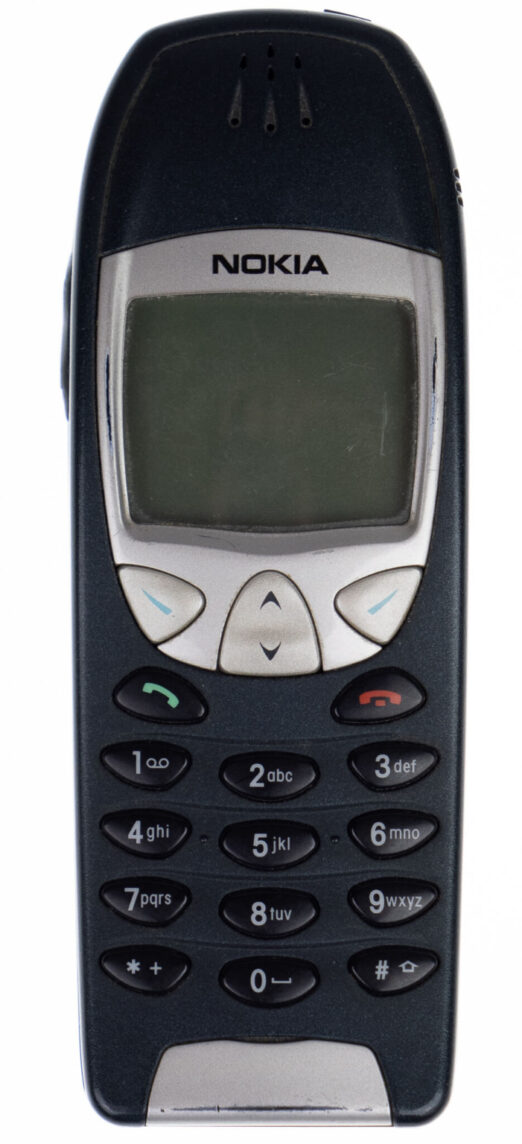

IT-Exzellenz seit 1973.

Eine Vergangenheit, auf die man stolz sein kann. Eine Zukunft, auf die man gespannt sein darf.

Die Ratiodata blickt auf über 50 Jahre Unternehmensgeschichte zurück. Begleiten Sie uns auf eine Reise durch fünf Jahrzehnte und erleben Sie, wie sich die Ratiodata im Laufe der Zeit entwickelt hat und gewachsen ist.

Aktuelle News